実験計画法とは

実験データの取得原則

実験計画法の概要とその重要性

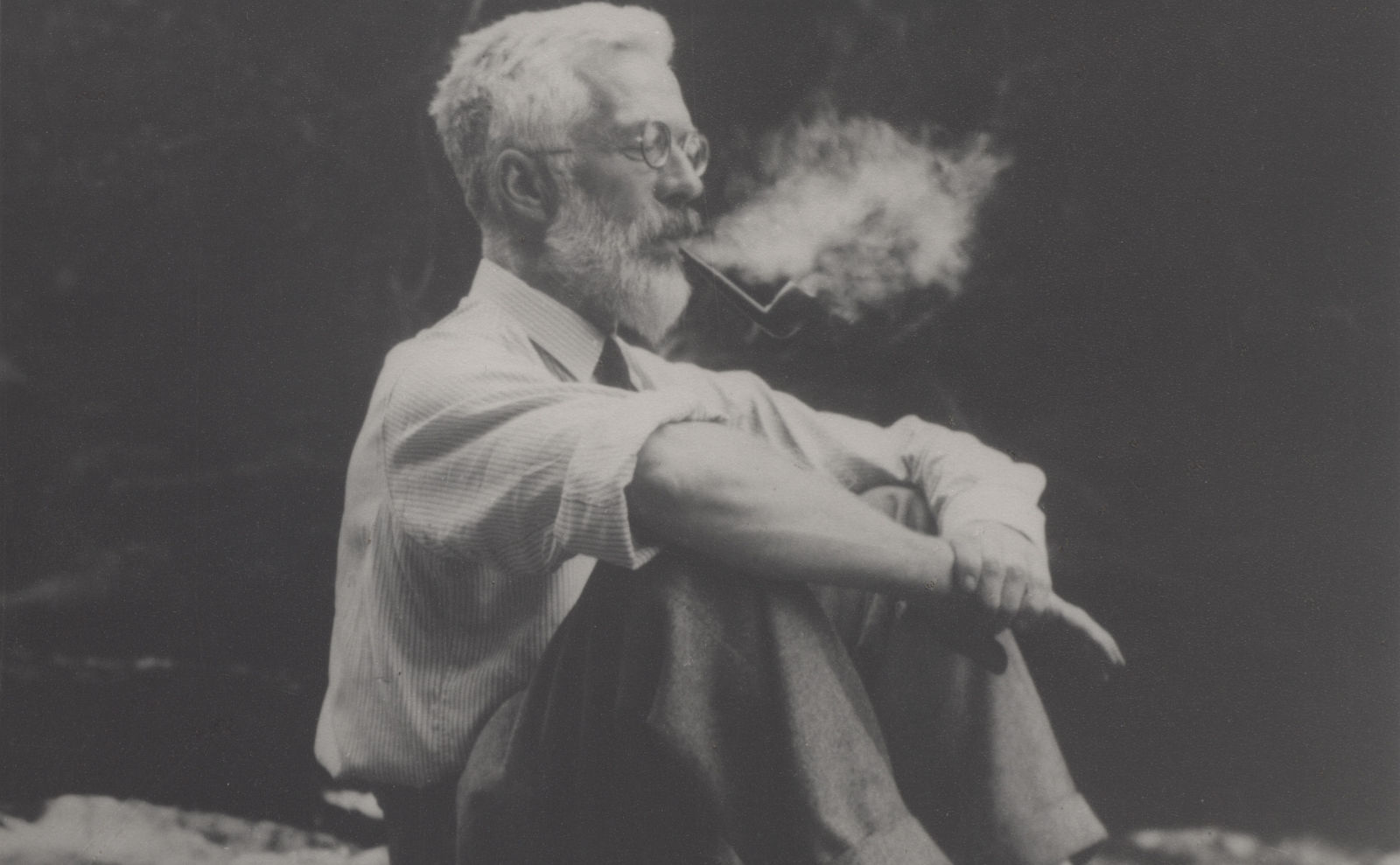

実験計画法は、現代統計学の基礎を築いたロナルド・エイルマー・フィッシャー博士によって開発されました。

この方法論は、実験データの設計と収集に対する科学的アプローチを提供します。

この計画法は、データ収集の基礎となり、製造業、医薬業界、市場調査など、多様な分野で広く採用されています。

特に、統計的品質管理においては不可欠な要素とされています。

フィッシャー博士の死後も、組合せ論を基盤として、この計画法は進化し続けています。

実験計画法には多くの要素がありますが、その中でもフィッシャーが提唱した基本的な三つの原則は、「フィッシャー三原則」として特に重要視されています。

局所管理化(ブロッキング)の原則

局所管理化、またはブロッキングと呼ばれるこの原則は、研究対象となる要因以外の影響を最小限に抑えるために重要です。

Webパフォーマンスなどの計測・監視において、局所管理化を実施する際の具体的な手法は以下の通りです。

- 機器スペックの統一

-

計測に使用する全ての機器のハードウェアスペックを統一します。

これにより、スペックの違いが結果に与える影響を排除します。 - ソフトウェア環境の統一

-

計測機器で動作するオペレーティングシステムやブラウザなどのソフトウェア環境も統一します。

ソフトウェアのバージョン差による影響を排除します。 - 他のアプリケーションの非稼働:

-

計測機器上で他のアプリケーションが動作しないように設定します。

これにより、コンテキストスイッチや割り込み処理による計測値への影響を排除します。

反復の原則

反復は、計測結果のバリエーション(バラツキ)を最小限に抑えるために不可欠です。

同一条件下で複数回の計測を行い、標本の大きさを増やすことで、大数の法則に従い、真の分布に近似していく結果、確率的に真の値に近づけることが可能です。

特にWebパフォーマンスなどの計測・監視においては、以下のような手法が採られます。

- 推奨される計測頻度

-

最低でも、15分ごとの計測が推奨されています。

これにより、1日に96回、1ヶ月には2,976回の計測が行え、分析に適したデータセットの大きさが確保されます。

標本分布のt分布表によれば、自由度が100に近づくと正規分布に近似するため、まずは標本の大きさは100近くまで確保することが目安とされています。

標本の大きさの設計については、永田靖先生の「サンプルサイズの決め方」(朝倉書店)という有名な本があります。

標本の大きさにより、検出力(統計的に有意な結果を見つける能力)が大きく変わってきます。

これは、第二種の過誤(遅延やエラーが発生しているのに、それを検出できない)を防ぐために重要です。 - 周期性の把握

- 定常的な計測を行うことで、日次、週次、月次といった時間パターン(タイムトレンド)を明らかにすることができます。

- 能動的監視

-

実験においては、能動的に値を取得します。

もしReal User Monitoringのように受動的に値を取ると、反復と次に出てくる無作為化の確保ができません。

そこで、Synthetic Monitoringが基本となります。

無作為化の原則

無作為化は、計測値の独立性を確保し、系統誤差を偶然誤差に変換する手段として非常に重要です。

この原則に従い、標本は無作為に選ばれます。

Webパフォーマンスなどの計測・監視では、以下のような手段が採られています。

- ランダム化された15分間隔

-

計測間隔を15分ごとにする場合、厳密に15分毎ではなく、一定のランダム性を持たせた15分前後で計測を行います。

これにより、特定のタイミングに依存する誤差を排除します。 - 回線・都市別での計測・監視タイミング

-

複数の都市や回線が対象となる場合、計測時間は各地で統一するか、地域ごとにランダムにするかが選択できます。

計測時間はランダム決定しても、その時間で一斉に各地で計測することで、エリアを超えたネットワークで発生した問題を統合的に判断することが可能になります。 - キャッシュクリアによる値の独立性

-

計測値の独立性を確保するため、計測が終了すると、キャッシュがクリアされます。

これにより、次の計測は、全くの新規アクセスと同じ状態となり、以前の計測が現在の計測結果に影響を与えることを防ぎます。